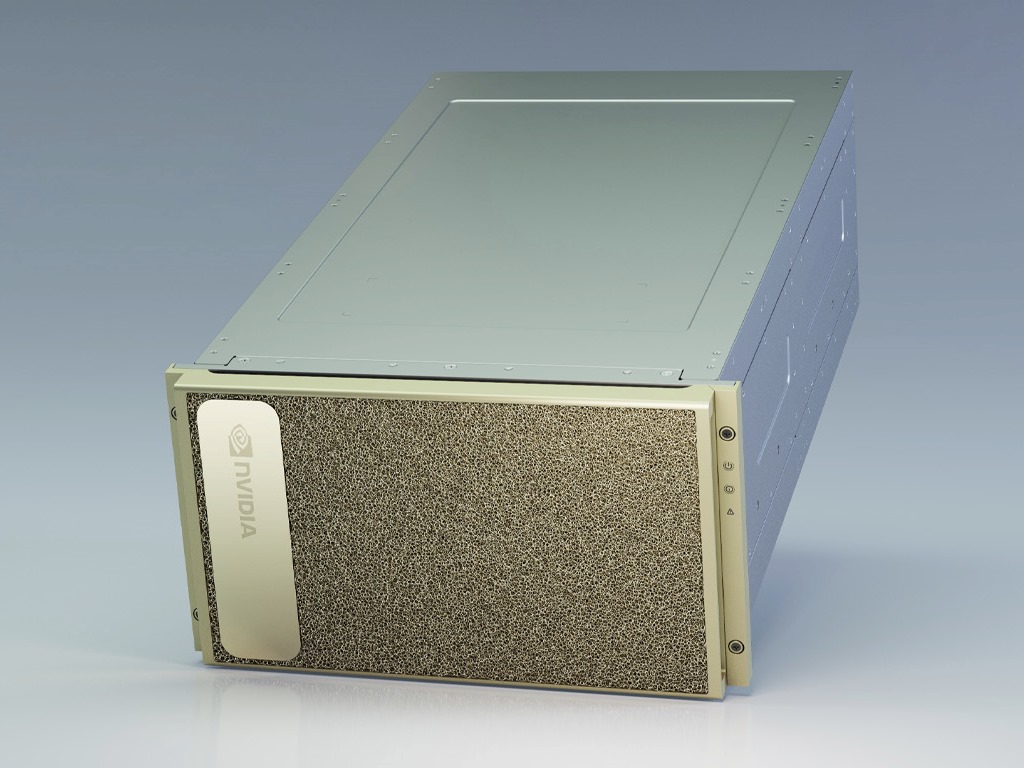

Nvidia DGX A100 (Bild: Nvidia)

Nvidia-CEO Jensen Huang hat bei seiner Keynote zur virtuellen Ausgabe der hauseigenen Technologiekonferenz GTC mehrere neue Produkte des Unternehmens vorgestellt. Darunter ist die neue auf Rechenzentren ausgerichtete GPU A100, die auf der neuen Ampere-Architektur basiert.

Nach Angaben des Unternehmens stellt Ampere die bisher größte Weiterentwicklung gegenüber einer Vorgeneration dar. Die für High Performance Computing optimierte Multi-Instanz-GPU soll 20 mal mehr Leistung bieten als ihr Vorgänger Volta. Ermöglicht wird dies unter anderem durch 54 Milliarden Transistoren, die die GPU zum weltweit größten 7-Nanometer-Prozessor machen sollen.

Neu ist auch eine Multi-Instance GPU genannte Funktion, die es erlaubt, eine einzelne A100-GPU in bis zu sieben unabhängige GPUs aufzuteilen – jede mit eigenen Ressourcen. Die dritte Generation der NVLink-Technologie soll zudem die Geschwindigkeit der Verbindungen zwischen GPUs verdoppeln, was es A100-Servern wiederum erlauben soll, als eine riesige GPU zu agieren.

Basierende auf der A100-GPU bietet Nvidia auch eine neue Generation des AI-Systems Nvidia DGX an. Das Nvidia DGX A100 genannte System soll wiederum der erste 5-Petaflops-Server sein. Jeder DGX A100 wiederum lässt sich laut Huang auf bis zu 56 Applikationen aufteilen, die alle unabhängig voneinander ausgeführt werden.

Erste Abnehmer des DGX A100 sind das Argonne National Laboratory des US-Energieministeriums. Es setze die AI- und Rechenleistung des Systems unter anderem für die Erforschung von COVID-19 ein. Weitere Kunden seien die University of Florida und das Deutsche Forschungszentrum für Künstliche Intelligenz.

Huang betonte bei seiner Keynote auch Kostenvorteile durch die hohe Leistungsfähigkeit des neues Systems. So soll ein Rechenzentrum mit fünf DGX A100 für AI-Training nur 28 Kilowatt Strom benötigen und eine Million Dollar kosten und dieselbe Leistung bieten wie eine Rechenzentrum mit 40 DGX-1-Systemen von Nvidia sowie 600 CPU-Systemen, die zusammen 11 Millionen Dollar kosten und 630 Kilowatt benötigen. „Je mehr Sie kaufen, je mehr sparen Sie“, kommentierte Huang.

Die A100-GPU soll aber auch im Bereich Cloud-Computing zum Einsatz kommen. Huang erklärte, dass unterem Amazon Web Services, Alibaba, Baidu, Cisco, Dell, Google, HPE, Microsoft und Oracle die GPUs in ihre Rechenzentrums-Architektur integrieren.

Darüber hinaus stellte Huang auch ein Merlin genanntes Software Development Kit vor, mit dem sich AI-basierte Empfehlungssysteme entwickeln lassen. Merlin soll die Zeit, die für eine Empfehlungssystem aus 100 Terabyte Daten benötigt werden von vier Tagen auf 20 Minuten reduzieren.

In diesem Webinar stellen wir Ihnen SkySQL vor, erläutern die Architektur und gehen auf die Unterschiede zu anderen Systemen wie Amazon RDS ein. Darüber hinaus erhalten Sie einen Einblick in die Produkt-Roadmap, eine Live-Demo und erfahren, wie Sie SkySQL innerhalb von nur wenigen Minuten in Betrieb nehmen können.

Sie erlauben unter anderem das Einschleusen und Ausführen von Schadcode aus der Ferne. Betroffen sind…

Betroffen sind alle unterstützten Windows-Versionen. Der März-Patchday beseitigt sieben Zero-Day-Lücken und sechs als kritisch eingestufte…

Der neue Patch ergänzt eine Fehlerkorrektur aus Januar. Er soll einen Sandbox-Escape in Safari unter…

Die Gruppe greift neuerdings auch Ziele in Europa an. Ziel der Angriffe sind Betriebsdaten, Forschungsprojekte…

Mindestens zwei Anfälligkeiten lassen sich aus der Ferne ausnutzen. Betroffen sind Chrome für Windows, macOS…

Sind Sie es leid, dass langsame, komplizierte PDF-Editoren Ihre Zeit verschwenden? Damit sind Sie nicht…