Innerhalb der vergangenen zwei Jahre erlebten HPE-Kunden, dass mehr und mehr der HPE-Hardwareprodukte auch in Service- und verbrauchsorientierten Konsummodellen für den Vor-Ort-Einsatz angeboten werden. Auf der HPE Discover More 2019, einer auf die DACH-Region und Russland fokussierten Kongressmesse in München, zeigte HPE nun den nächsten Schritt auf diesem Weg.

Er heißt HPE GreenLake Central. Die Konsole, die schon bald alle 700 derzeitigen GreenLake-Kunden von HPE verwenden sollen, verwaltet alle GreenLake-Services, die ein Unternehmen verwendet und dazu die genutzten Public-Cloud-Services von AWS und MS Azure. Google folgt bald. „Die Welt ist hybrid“ betonte diesbezüglich Flynn Melloy, Vice President Marketing GreenLake Central. Nicht alle Applikationen seien derzeit fit für die Public Cloud – wegen zu großer Datenmengen, aus Compliance-Gründen oder weil sie nicht für die Cloud entwickelt wurden. „Unsere Kunden wollen dieselbe Nutzungserfahrung wie in der Cloud, aber On Premises“, sagte Melloy. Das biete GreenLake Central.

In die neue Konsole sind auch Funktionen des bisherigen, vor nicht allzu langer Zeit angekündigten Cloud-Management-Tools HPE One Sphere eingeflossen. Für dieses, so Scott Yow, GreenLake Vice President und Geschäftsführer HPE, habe man zuvor noch nicht sehr viele Kunden akquiriert, die nun sämtlich auf das GreenLake-Produkt umgestellt werden.

Das Rollout der Lösung erfolgt bis Ende des ersten Quartals 2020 an rund ein Viertel der derzeit weltweit etwa 700 GreenLake-Kunden als Test. Im zweiten Quartal 2020 wird das Portal dann allen GreenLake-Kunden zur Verfügung gestellt. Das Portal allein kostet nichts, wohl aber zusätzlich dazugebuchte Mehrwertservices, etwa spezifische analytische Dienste. Wie Till Stimberg, Director Hybrid IT Category DACH bei HPE, berichtete, ist im deutschsprachigen Raum beispielsweise Bosch Informatik in Österreich ein GreenLake-Kunde.

Point-and-Click einheitlich für GreenLake und Public Cloud

Was macht nun in HPE-Augen die neue Zentralkonsole so einmalig? Erstens die Selbstbedienungsfunktion, die es ermöglicht, neue Ressourcen per Point-and-Click zu ordern. Zweitens die Integration der Managementdaten aus AWS, Azure und der On-Premises-GreenLake-Infrastruktur unter einer Oberfläche mit einer einheitlichen Schnittstelle, die beispielsweise die nahtlose Portabilität von Anwendungen zwischen allen gemeinsam verwalteten Welten ermöglicht. So können alle Gold-Images und Cloud-native-Tools in GreenLake-Umgebungen auch On Premises werden.

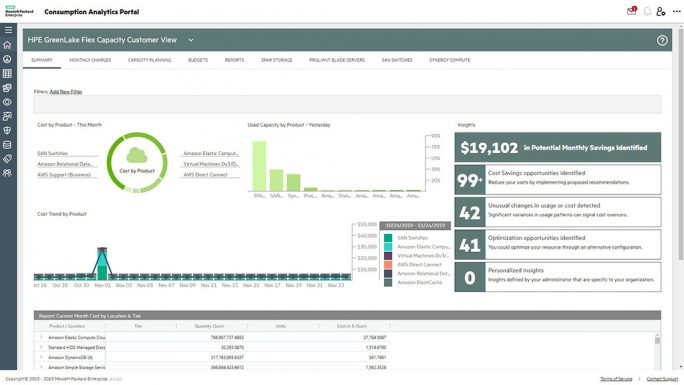

Drittens eine ausgefeilte Analytik, die beliebig fein granuliert und verschachtelt werden kann. Damit lassen sich beispielsweise Kosten nahezu beliebig Lokationen, Apps, Nutzergruppen etc. zuordnen. Außerdem überwacht die Analytik die genutzten Kapazitäten. Das soll einem ungeliebten Cloud-Problem der gestrandeten, aber nach wie vor zu bezahlenden Ressourcen On Premises und in der Public Cloud den Garaus machen. Laut Yow habe zum Beispiel ein Unternehmen, das derzeit HPE GreenLake Central ausprobiert, auf einen Schlag eine Million Dollar eingespart. So werde es auch möglich, einen effektiven Kapitaleinsatze durch eine einheitliche Kostensicht über alle verwendeten Plattformen hinweg besser sicherzustellen.

Eine Spezialsprache für Compliance-Regeln

Schließlich sorgt das Portal auch permanent für Compliance und Datenschutz sowie Risikovorsorge, vor allem durch Konformität mit komplexen Regelwerken wie der DSGVO oder HIPPAA fürs US-Gesundheitswesen. Die Konsole ermöglicht eine exakte und kontinuierliche Datenzugriffskontrolle und Rechtevergabe und deren Abgleich an geltenden Regelwerken. Zudem hat HPE eigens eine an natürliches Englisch angelehnte Sprache für Nicht-IT-Spezialisten entwickelt, mit der sich kundenspezifische Regeln für den Datenzugriff ohne Programmierkenntnisse schreiben und in der GreenLake-Umgebung aktivieren lassen.

Etwas unklar waren die Aussagen des HPE-Managements hinsichtlich der Nutzbarkeit von HPE GreenLake Central auf Hardware von Drittherstellern. Fasst man die Aussagen zusammen, ergibt sich etwa folgendes Bild: Für den Vertrieb mit Dritthersteller-Hardware ist die Lösung nicht vorgesehen, unter anderem wegen der geplanten engeren Verzahnung von Hard- und Softwarefunktionen. Kunden, die neue Implementierungen planen, sollen, um GreenLake Central nutzen zu können, Hardware möglichst als GreenLake-Service beziehen. Brownfield-Kunden, deren Dritt-Hardware aktuell weiter genutzt werden soll, können trotzdem auf HPE GreenLake Central hoffen, wenn sie bereit sind, Schritt für Schritt auf HPE-GreenLake-Services wie Composable Infrastructure, Simplivity, Nimble, die anwendungsspezifischen Komplettstacks beispielsweise für SAP oder andere Lösungen, die bereits per GreenLake as-a-Service angeboten werden, umzusteigen.

HPE-Manager Stimberg betont, das Interesse daran sei bei den Kunden groß. Mitnichten sei das GreenLake-Modell nur HPE-Bestandskunden interessant. Bis zur Hälfte der Nutzer habe es letztlich darauf abgesehen, die bisherige IT-Hardware durch das nutzungsorientiert abrechnende und wie Public-Cloud-Service betriebene GreenLake-Modell abzulösen oder investiere ganz neu in die Services.

Unisono betonte das Management, dass die Kunden sich nicht mehr für die Hardware interessierten, sobald sie das GreenLake-Modell verstanden und ausprobiert hätten. „Sie kommen zu uns und wollen einfach die bestmögliche Umgebung für eine Workload mit bestimmten Leistungs- und Verfügbarkeitsanforderungen“, sagt beispielsweise Paul Miller, Vice President Marketing Software und Cloud.

Doch ewig rollt der Servicetruck…

Das Point-and-Click-Verfahren bei Kapazitätserweiterungen hat allerdings seine Grenzen. Denn wenn die Hardware zu Ende geht, rollen nach wie vor Pointnext-Berater beim Kunden an, um die nächste Ausbaustufe sinnvoll zu gestalten. Dafür ist allerdings kein Honorar fällig. „Bezahlt wird erst, wenn die neuen Ressourcen auch genutzt werden“, beteuert Stimberg. Von der Bestellung per Point-and-Click zwecks Hardwareerweiterung bis die neue Hardware arbeitsbereit ist, können ein bis zwei Wochen vergehen.

Um dem wachsenden Servicegeschäft gerecht zu werden, hat HPE seine servicebezogene Buchführung auf das Kriterium „Annual Revenue Run Rate“ umgestellt. Es umfasst neben den Mieten für die einzelnen Services, bereits gebuchten oder genutzten Pointnext- und GreenLake-Services auch die Zinsen für das Kapitalleasing bei Finanzierung durch HPE Für Jahreswerte wird der jeweilige Quartalswert vervierfacht. Derzeit beträgt der so errechnete Serviceumsatz knapp 14 Prozent mit einem jährlichen Wachstum von 30 bis 40 Prozent. Diese Wachstumsrate soll auch innerhalb der nächsten drei Jahre beibehalten werden, der Anteil der Services am Gesamtumsatz wird also steigen.

Zudem, so betonte man seitens des Managements, habe man inzwischen auch rund 500 Channelpartner für das neue Modell begeistern können, deren Umsätze mit GreenLake-Services um dreistellige Prozentwerte zulegen.

Container-Plattform macht die vorletzte Applikationsgeneration Cloud-fähig

Zu weiterem Wachstum soll auch die Mitte November dieses Jahres auf der Kubernetes-Konferenz CubeConf vorgestellte HPE Container Platform beitragen. Sie wird ebenfalls als GreenLake-Service angeboten. Die Plattform vereinigt die Fähigkeiten der Managementplattform BlueData für das einheitliche Management von Umgebungen mit mehreren parallel arbeitenden Kubernetes-Clustern und die enterprisetaugliche Hadoop-Lösung für die unterliegende Storage von MapR. Beides sind relativ aktuelle Aufkäufe von HPE. Demnächst kommt Original-Kubernetes für das Management einzelner Containercluster hinzu – bislang dient dazu bei HPE eine proprietäre Software. Mögliche Anwendungsfelder sind neben AI/ML/Big Data auch Softwareentwicklungspipelines und ähnliche Felder.

HPE betont, dass HPE Container Platform dank eines patentierten Verfahrens die Migration von nicht Cloud-nativen monolithischen Anwendungen auf Container ermögliche. Wer nun aber glaubt, dies betreffe die gigantischen Finanz- oder andere Applikationen aus der Cobol-Welt, die oft aus blankem Mangel an Alternativen noch auf dem Mainframe laufen, der irrt. Gemeint ist vielmehr die erste, vielleicht zehn Jahre alte Generation der Kubernetes-, Spark-, Kafka-, Ansible- oder Hadoop-Software, die noch nicht für die Cloud entwickelt wurde. Davon gebe es genug, meinte Miller, um hier ein profitables Geschäftsfeld aufzumachen. Vertrieben wird die Plattform übrigens derzeit mit Apollo-Hardware, für die es ein Referenzdesign gibt. Apollo wiederum ist ein Ergebnis des vor einigen Jahren propagierten Moonshot-Projekts.

Auf zu neuen Höhen mit SkySQL, der ultimativen MariaDB Cloud

In diesem Webinar stellen wir Ihnen SkySQL vor, erläutern die Architektur und gehen auf die Unterschiede zu anderen Systemen wie Amazon RDS ein. Darüber hinaus erhalten Sie einen Einblick in die Produkt-Roadmap, eine Live-Demo und erfahren, wie Sie SkySQL innerhalb von nur wenigen Minuten in Betrieb nehmen können.